Choqué ! Le secret de l'utilisation de la 3D pour créer de l'animation 2D enfin révélé

En tant qu'amateur d'anime, vous êtes-vous déjà demandé comment les animations étaient réalisées ? En particulier les animations 2D qui sont réalisées en 3D. Dans cet article, le meilleur fournisseur de services de rendu cloud CPU & GPU, Fox Renderfarm, vous révèle les secrets méconnus de l'utilisation de la 3D pour créer de la 2D. Une découverte garantie pour vous étonner !

La fille au style bande dessinée met sa main devant son visage et fait un geste mignon, comme si elle était un peu timide face à la caméra…

Les amateurs d'anime ont toujours été frappés par des compositions similaires. En effet, une telle perspective intime permet de se sentir infiniment plus proche des personnages à l'écran.

Mais une fois que l'on connaît la vérité, on se sent très loin d'eux.

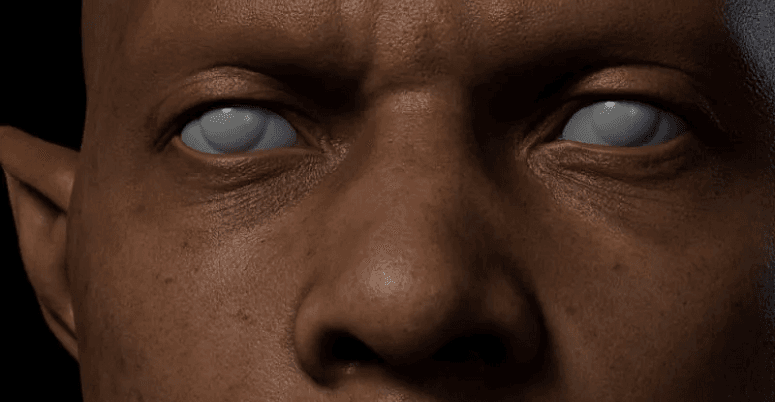

Un personnage tout à fait normal dans le plan, ressemblant à un monstre à main géante sous d'autres angles.

Il s'agit d'une histoire interne dont beaucoup d'acteurs de l'industrie de l'animation 3D évitent de parler. Ce que vous voyez n'est peut-être pas aussi bon qu'il n'y paraît :

La vérité "brutale" des coulisses qui pourrait briser le rêve de certains fans d'ACGN.

Et ce ne sont là que quelques-uns des éléments qui entrent en jeu dans l'animation 3D.

En tant que spectateurs, nous sommes souvent frappés par l'expressivité des animations à l'écran, mais il est difficile de penser aux astuces "trompeuses" inattendues qui se cachent derrière...

Par exemple, ces personnages à l'allure mignonne et câline peuvent avoir un modèle de bouche tordue.

Récemment, un passionné d'anime japonais, さんご, a annoncé son anime autoproduit, Bite the Bullet.

Dès sa sortie, l'anime est rapidement devenu un sujet brûlant dans la communauté japonaise de l'anime. La première chose que les gens ont admirée, c'est la haute qualité qu'il affiche.

Mais ce n'est pas tout. Avec cela, l'auteur さんご a partagé une partie du processus de production 3D de Bite the Bullet.

Ce que ces images du processus ont révélé a surpris de nombreux spectateurs : par exemple, certaines images d'animation où le personnage "parle de côté" cachent en réalité un modèle de bouche déformé.

Le plan esthétique de la jeune fille regardant vers le bas dépend de l'interprétation de l'homme monstrueux.

Le mystère de l'animation 3D a été levé avec l'apparition de ces images de production. Les vérités "brutales" ont été révélées à un grand nombre d'utilisateurs, qui ont soupiré "Ah, c'est donc comme ça...".

Mais dans le cas de l'animation 3D, il ne s'agit là que de la technique de "tromperie" la plus élémentaire.

Comme nous l'avons vu, la plupart des anime ont un aspect qui ne nous semble pas étrange, sauf si nous y réfléchissons.

Le personnage montre un visage de côté, mais une bouche complète est visible.

C'est une façon de présenter le tableau de manière à en réduire le coût. Avec son utilisation intensive, il est devenu un phénomène qui n'est pas rare pour les téléspectateurs.

Certaines animations 3D (notamment en cel-shading) doivent volontairement incliner la bouche à un angle précis lors de l'ajustement du modèle afin d'obtenir le même effet.

Cette façon de dessiner est plutôt contre-intuitive, mais c'est l'une des techniques courantes de l'animation 3D : "détruire" l'intégrité du modèle lui-même au profit de l'expressivité.

En bref, le modèle n'est peut-être pas aussi "harmonisé" que vous le pensez, là où l'observateur ne peut pas le voir.

À mesure que de plus en plus de créateurs d'animation 3D dévoilent le processus de réalisation de leurs œuvres, les secrets qui se cachent derrière commencent à être révélés.

Par exemple, dans le résultat final, on trouve une image assez puissante de rugissement.

Mais cela peut paraître un peu bizarre sur la face avant.

鈴木大介, directeur CG de l’anime Bubuki/Buranki, a expliqué en détail une scène de la production : "Cette image utilise un plug-in pour ajouter des coups de pinceau aux lignes de contour, tandis que les dents postérieures, absentes du modèle, ont été remodelées et intégrées. C’est un exemple typique - le modèle 3D a été affiné pour ressembler à de la 2D."

Le spectateur ne peut voir que l'image finale. L'artiste doit souvent s'efforcer de rompre la cohérence du modèle afin de tirer le meilleur parti d'un angle particulier.

Pour la plupart des productions 3D, la réalité peut être très différente de ce à quoi on pourrait s'attendre dans des endroits qui ne sont pas visibles pour le spectateur.

Un joueur a exploré le jeu Dragon Ball FighterZ et est connu pour avoir révélé certains contenus invisibles aux spectateurs occasionnels.

Dragon Ball FighterZ est un jeu de combat dynamique publié par Bandai Namco Holdings. En tant qu’adaptation de manga, il met fortement l’accent sur la performance des combats en jeu et a reçu de nombreux éloges pour cela.

Bien que le jeu adopte une perspective traditionnelle de combat horizontal en 2D, les personnages sont modélisés en 3D, avec de brefs changements de perspective et des mises en scène spécifiques selon les compétences utilisées.

Un YouTubeur du nom de sigmaG19 a effectué quelques manipulations pour corriger la perspective du jeu et a ensuite partagé des images plus "réalistes" du jeu.

C'est par contraste que l'on comprend comment certaines performances extrêmement tendues sont réalisées. L'exemple le plus classique est l'animation du grand mouvement de Son Gohan. En action réelle, il se présente comme suit :

L’animation offre délibérément un gros plan sur les mains du personnage, rendant le mouvement global extrêmement intense. Et si vous regardez cette scène sous une perspective fixe, vous verrez que l’effet ci-dessus est en réalité obtenu en augmentant drastiquement la taille des mains :

Il existe plusieurs séquences d'animation similaires. Une fois la caméra et la perspective absentes, l'effet visuel réel devient légèrement étrange.

Certains acteurs du secteur de l'animation qualifient cette technique de "tromperie nécessaire".

La "tromperie" consiste à "détruire" la cohérence du modèle en le déformant, l'agrandissant ou le réduisant afin d’accentuer la tension de l’image.

Le créateur de l’animation CG du jeu destiné au public féminin IDOLiSH7 a démontré une technique similaire.

Dans l’une des animations CG du jeu, un personnage est montré de profil avec ses fesses légèrement exposées.

Afin d'obtenir la "rondeur" visible sur l'image, l'équipe de production a en réalité ajouté des coussinets de hanches à un modèle initialement plat.

Étant donné que les dessins animés ont souvent des effets exagérés similaires, il n'est pas particulièrement surprenant pour les spectateurs que certaines actions ou certains effets ne soient pas "logiques".

Par "pas raisonnable", il faut entendre que "ces images ne peuvent pas être "réalisées" dans la réalité".

L'une des images les plus typiques est l'action d'Ultraman : Ultraman s'envole vers l'avant, le poing levé.

Les grands poings d'Ultraman donnent à l'ensemble de l'image un impact très dynamique. Mais pour réaliser cette pose dans la réalité, il faudrait accepter d'avoir un Ultraman disproportionné.

Dans la vue 2D, le héros Ultraman va jusqu'au bout. Mais dans le monde 3D, il s'agit plutôt d'un homme en caoutchouc qui peut étirer ses membres.

Cette technique consistant à mettre un accent déraisonnable sur certaines parties du corps afin de rendre l'image plus expressive porte désormais un nom propre : la perspective du mensonge (嘘パース).

Pour les fans d'anime, il y a de fortes chances que vous ayez été "trompé" de nombreuses fois par la perspective du mensonge sans vous en rendre compte.

Les fans d'anime et de manga seront probablement impressionnés par l'image d'un personnage brandissant un poing ou une arme devant l'écran.

Vous pouvez avoir le vague sentiment que la composition n'a pas de sens, mais vous ne vous rendez pas compte à quel point elle n'a pas de sens.

Dans certaines animations en 2D, où l'accent est mis sur l'impact, ce type d'image est souvent critiqué parce qu'il est "difficile de trouver comment faire une telle pose".

Et la production d'animation 3D donne la réponse : trouver des excuses.

Il y a une scène dans l'anime High Score Girl où la protagoniste féminine frappe durement le protagoniste masculin au visage.

Le spectateur, qui ne voit qu'une scène aussi brève dans la production, invente automatiquement les parties hors champ et les rationalise naturellement.

Mais en y regardant de plus près, on s'aperçoit que ce type d'image ne peut pas être réalisé dans la réalité. Au lieu de cela, l'animation 3D utilise la pose afin de rendre l'idée réelle.

Si seul un objectif grand angle est utilisé pour obtenir un effet similaire, le visage du personnage sera également déformé.

Les plans similaires que nous voyons souvent dans les travaux en 3D sont essentiellement obtenus en déformant et en modifiant les membres modélisés.

Ce "trucage" inoffensif donne aux images normales une impression plus exagérée d'animation en 2D.

Dans de nombreux endroits inattendus, vos yeux ont peut-être été trompés par l'appareil photo !

Et cette perspective de mensonge améliore grandement la performance de l'image. Un modélisateur a partagé une comparaison avant/après du redimensionnement des pieds d'un personnage, et l'effet est très visible :

C'est aussi grâce à cet excellent effet que la perspective du mensonge est aujourd'hui omniprésente.

Il convient également de noter que cette technique d'exagération "irrationnelle" était déjà utilisée il y a plusieurs décennies.

Entre les années 1970 et le milieu des années 1980, un artiste nommé Kanada Yoshinori a eu un impact considérable sur l'industrie de l'animation japonaise. Il a travaillé sur plusieurs animations classiques telles que Getter Robo G, Ikkyū-san et GeGeGe no Kitarō, et était connu pour ses techniques de dessin uniques.

Dans le processus de dessin de Kanada Yoshinori, il utilisait souvent une technique spéciale : exagérer la distance et la proximité des personnages/objets – en agrandissant les éléments proches et en réduisant ceux qui sont éloignés.

L'image ainsi manipulée comporte évidemment de nombreuses erreurs de perspective. Mais il s'agit d'une image expressive convaincante :

L'impact de ce style de peinture sur l'ensemble de l'industrie a été incommensurable. Il est également connu sous le nom de "perspective Kanada" et constitue l'une des pierres angulaires de la méthode du mensonge.

Aujourd'hui encore, ces innombrables "tromperies" sont perpétrées dans diverses productions.

Bien que le public soit susceptible de crier à la "tromperie" en découvrant la vérité, il n’en est pas pour autant fautif.

En tout état de cause, il s'agit là de mensonges de l'ACGN, et de mensonges bien intentionnés.

Voici les secrets de l’utilisation de la 3D pour créer de l’animation 2D que Fox Renderfarm vous révèle. En tant que leader des services de ferme de rendu cloud, Fox Renderfarm continue de vous apporter les dernières actualités sur l’art 3D ! Si vous ne savez pas ce qu’est une ferme de rendu, découvrez Fox Renderfarm, un outil exceptionnel qui vous aide à créer des modèles ou animations 3D.

Recommended reading

Top 9 Best And Free Blender Render Farms of 2025

2024-12-30

What is Jibaro? Reveal the Story and Techniques Behind the Production of Jibaro "Love, Death & Robots"

2025-11-03

Top 10 Free And Best Cloud Rendering Services in 2025

2025-03-03

9 Best & Free 3D Rendering Software for Architects & Designers

2025-12-08

Top 8 After Effects Render Farm Recommended of 2025

2025-02-10

Easy Cel Shading Tutorial for Cartoon in Blender Within 2 Minutes

2025-11-26

Shocked! The Secret Behind Using 3D to Make 2D Animation was Revealed!

2025-02-10

How to Render High-quality Images in Blender

2024-12-04

Partners

Previous: Les 5 meilleurs logiciels de rendu 3D gratuits en 2025

Next: Les 8 meilleures fermes de rendu After Effects recommandées en 2025

Interested